[Anm. d. Red.: DieserArtikel schließt eine dreiteilige Serie zum Thema Datenmanagement ab. Siehe auch Newsletter Januar 2019 und Infoheft 51]

Sie kennen die Situation? Ihre Ehefrau, Ihr Ehemann, Ihre Kinder, Ihre Eltern haben bald Geburtstag. Ihr Finger fährt federartig mit elegantem Schwung über das Display des Smartphones, um den Warenkorb mit den letzten Geschenkartikeln zu füllen. Ein Klick noch und der Einkaufsbummel ist beendet – die freudigen Gesichter Ihrer Liebsten vor Augen sind Sie erleichtert, denn Sie haben dieses Jahr frühzeitig begonnen, die Geschenke zu kaufen. Die Anzeige sagt Ihnen „Vielen Dank für Ihren Einkauf! Ihre Ware wird in voraussichtlich 1-3 Werktagen zugstellt.“ Heute ist die Sendung bereits 4 Tage überfällig. Ihre Leichtigkeit von vor 7 Tagen schwindet. Sie fragen sich, was los ist, wo bleiben die Geschenke, ist meine Adresse richtig hinterlegt? War der Liefertermin korrekt, d.h. sind die Verfügbarkeitsinformationen richtig gewesen?

Die Rückkopplung zu dem Unternehmen, das hinter der Verkaufsplattform steht, wird unvermeidlich. Womöglich kaufen Sie die Geschenke an anderer Stelle und stornieren Ihre Bestellung. Das betroffene Unternehmen muss interne Prüfungen durchführen, das Problem identifizieren, ggf. selbst Artikel Retour setzen oder bleibt auf den Waren im schlechtesten Fall sitzen. Es entstehen für das Unternehmen Kosten, weil Daten nicht korrekt waren. Für Sie entstehen Unannehmlichkeiten, im schlechtesten Fall können Sie Ihr Ziel, Ihre Liebsten zum Geburtstag zu überraschen, nicht erreichen.

Die wenigsten von uns können behaupten, dass wir solche Erfahrungen in der nahen Vergangenheit gemacht haben. Die Online-Shops (E-Commerce) und logistischen Unternehmen sind in Fragen der Datenhaltung meist zuverlässig, die dahinterliegenden IT-Systeme und Organisationen auf solche Herausforderungen im Umfeld Big Data[1] eingestellt. Doch was genau heißt das: Darauf eingestellt sein? Und was bedeutet das mit Blick auf die Logistik der Bundeswehr?

Logistische Prozesse als Bedarfsträger von Daten

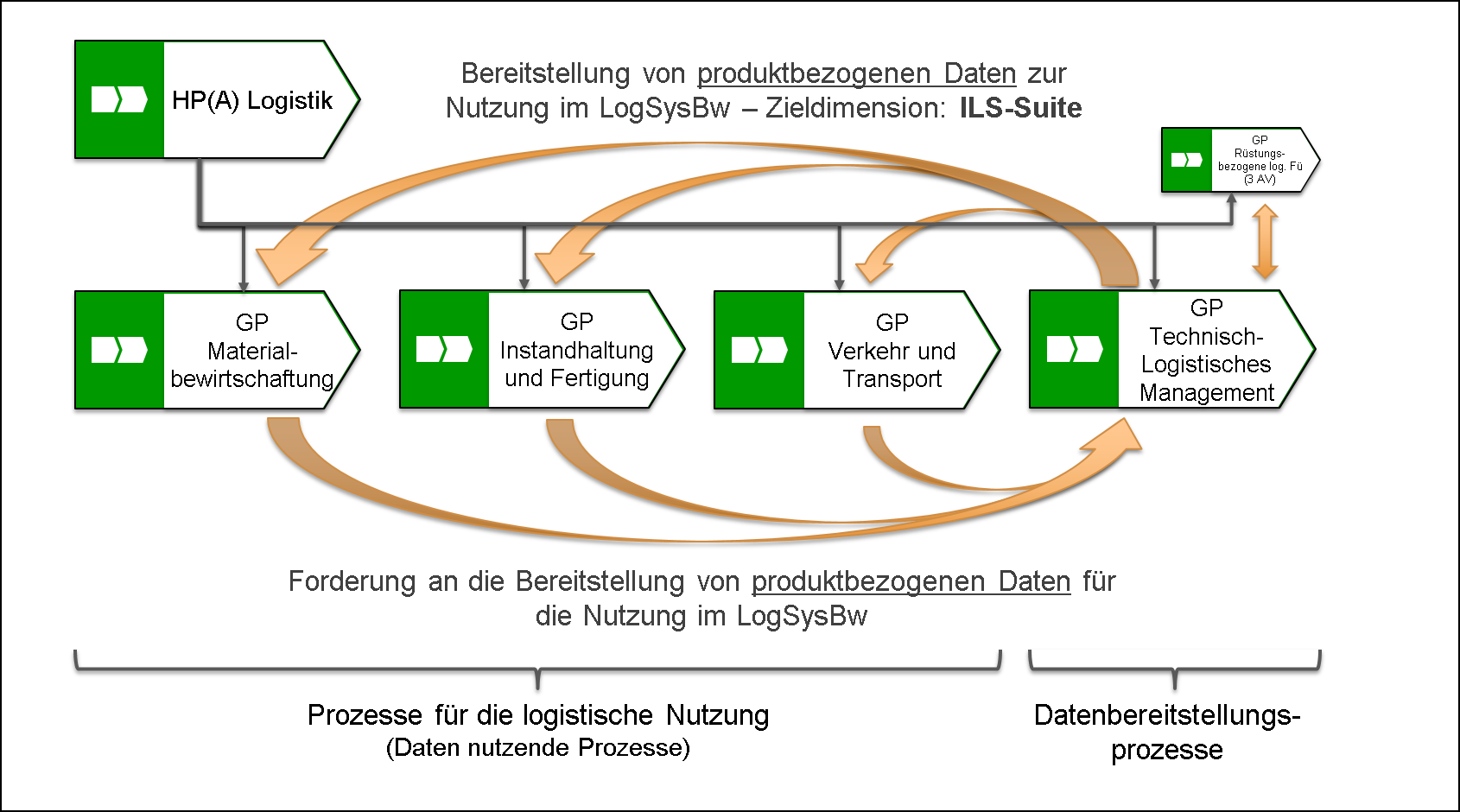

Die Bundeswehr stützt sich für die Bewältigung fachlicher Aufgabenstellungen in der Logistik und darüber hinaus auf integrative[2] Prozesse. Als konkrete Bedarfsträger von Daten treten in der Logistik vier Geschäftsprozesse (GP) auf

- GP Materialbewirtschaftung (MatBew),

- GP Instandhaltung und Fertigung (IHF),

- GP Verkehr und Transport (VuT),

- GP rüstungsbezogene logistische Führung[3] (LogFü).

Der darüber hinaus existierende GP Technisch-Logistisches Management (TLM) hat mit Bezug auf das Datenmanagement in der Logistik eine besondere Rolle. Er beschreibt als Teil seiner Aufgabe die Bereitstellung der für die Nutzung von Produkten im Logistischen System der Bundeswehr (LogSysBw) erforderlichen Daten. Dabei hat er die logistischen Prozesse zu reflektieren, die Anforderungen an die produktbezogenen Daten der nutzenden Prozesse zusammenzuführen, zu konsolidieren und zu harmonisieren – der Blick geht dabei immer von der Rüstung beginnend in das LogSysBw und zurück in die Rüstung. Die Operationalisierung der produktbezogenen Daten erfolgt als Gegenstand der logistischen Prozesse (Was soll bewirtschaftet werden? Was soll instandgehalten werden?) in den Geschäftsobjekten[4] der logistischen GP. Kernelement der Konsolidierung und Harmonisierung von Daten in der Logistik sind die Spezifikationen und Standards der S-Serie der ILS[5]-Spezifikationen (auch ILS-Suite genannt) im Rahmen der Zusammenarbeit mit der Industrie. Für die Sicherstellung der logistischen Interoperabilität im Bündnisrahmen der NATO bildet die Katalogisierung die Harmonisierungs- und Konsolidierungsbasis. Sie greift für deutsche Hersteller jedoch bereits auf die Vorgaben der S2000M[6] als Teil der ILS-Suite zurück.

Abbildung 1: Logistische Prozesse als Bedarfsträger von Daten

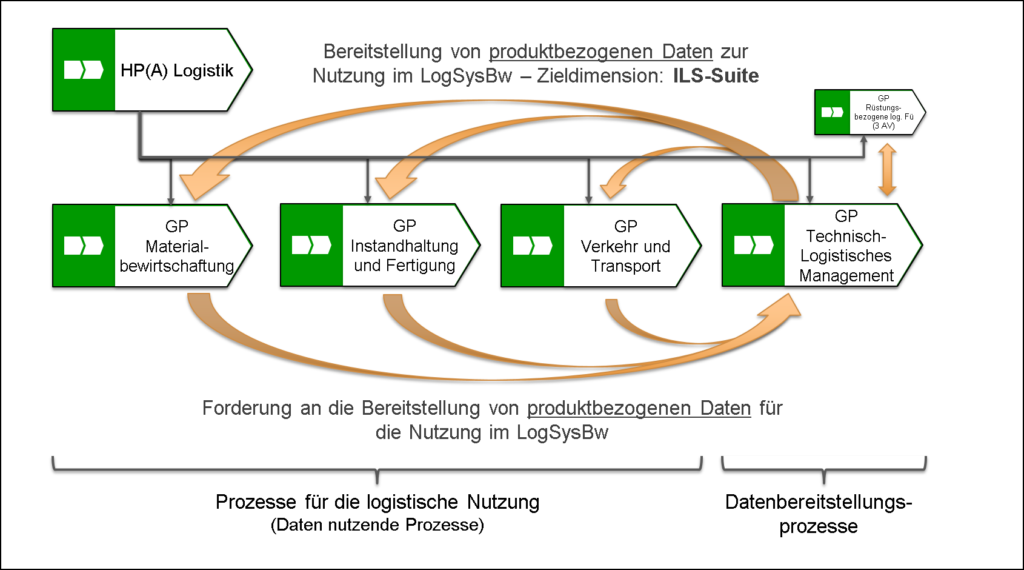

Die Identifizierung der erforderlichen Daten ist ein wesentlicher Bestandteil bei der Realisierung IT-gestützter Prozesse. Mit Hilfe von Informationsobjekten werden an einzelnen Arbeitsschritten innerhalb des Prozessmodells die dort erforderlichen Informationen[7] hinterlegt. Über das Informationsobjektmapping erfolgt im Rahmen der Realisierung die Identifizierung der Anforderungen an die Daten, die zur Bereitstellung der Informationen erforderlich sind. Die Datenmodellierung ist somit unmittelbarer Bestandteil der Prozessmodellierung[8].

Abbildung 2: Datenmodellierung als Teil der Prozessmodellierung

Die auf diese Weise festgestellten Datenbedarfe und -anforderungen sind regelmäßig Grundlage für die Definition von Qualitätsanforderungen an die Daten. Darüber hinaus bestimmen sie in der Logistik die Forderungsgrundlagen für die Bereitstellung produktbezogener Daten, die im Rahmen der Rüstungsprojekte beauftragt und durch die Industrie an die Bundeswehr geliefert werden müssen. Die hierzu erforderlichen Konsolidierungs- und Harmonisierungsmaßnahmen werden durch den GP TLM sichergestellt.

Mit Hilfe der Standard-Anwendungs-Software-Produkt-Familien (SASPF) werden die integrativen Prozesse dort mit IT unterstützt, wo dies effizient und betriebswirtschaftlich sinnvoll ist oder die Aufgabenstellung im Gesamtverbund des LogSysBw dies zwingend erfordert. Im integrativen System SASPF arbeiten derzeit über 60.000 Nutzer, mehr als 50 % bewegen sich in logistischen Prozessen – sie nutzen, produzieren und ändern Daten.

Daten stellen somit zugleich „Lebensader“ wie auch Output IT-gestützter logistischer Prozesse dar. Sie müssen Qualität[9] haben, d.h. für ihre Aufgabe im Prozess geeignet sein. Die Qualität von logistischen Daten ist im Kontext mit der starken Abstützung auf IT-gestützte Prozesse eine Voraussetzung, um den logistischen Auftrag erfüllen zu können. Sie ist Enabler für die fortschreitende Digitalisierung in der Bundeswehr. Mit dem Maß der Abstützung auf IT-gestützte Prozesse steigt somit der Nutzen wie auch die Bedeutung der Daten. Nur Daten mit Qualität haben einen Nutzen.

Die Logistik der Bundeswehr stützt sich in hohem Maße auf IT-gestützte Prozesse in SASPF ab. Um den erforderlichen Nutzen der Daten zu erreichen, bedarf es einer Organisation und eines Rahmenwerks, welche die notwendigen Maßnahmen im Datenmanagement anweisen, koordinieren, überwachen und durchsetzen kann. Dabei sind die verschiedenen Player im Prozess- und IT-Management zu berücksichtigen und zu verknüpfen. Diese Aufgabe übernimmt das Data Governance als organisatorisches Kernelement des Datenmanagements.

Data Governance als Kernkomponente im Datenmanagement

Data Governance ist ein Organisationskonzept. Es legt fest, welche Entscheidungen im Umgang mit Daten zu treffen sind und wer sie trifft. Darunter fällt die Definition von Rollen, Verantwortlichkeiten und Rechten im Umgang mit Daten in der Organisation. Data Governance schafft somit Richtlinien und Regeln für den Umgang mit Daten und sichert zugleich deren Einhaltung.

Abbildung 3: Datenmanagementrahmenwerk in der Bundeswehr als Zieldimension der Agenda Nutzung Teilprojekt Datenmanagement

Ziel ist, durch eine angemessene Qualität der Daten den bestmöglichen Nutzen (Prozessqualität) aus dem „Gut“ Daten zu erhalten. Dabei geht es nicht nur um die störungsfreie Nutzung der IT-gestützten Prozesse. Auch die Entscheidungsfindung in einem auf IT stark abgestützten Unternehmen basiert zu großen Teilen auf Daten. Somit erhöht die Qualität der Daten auch die Qualität der Entscheidungsfindung.

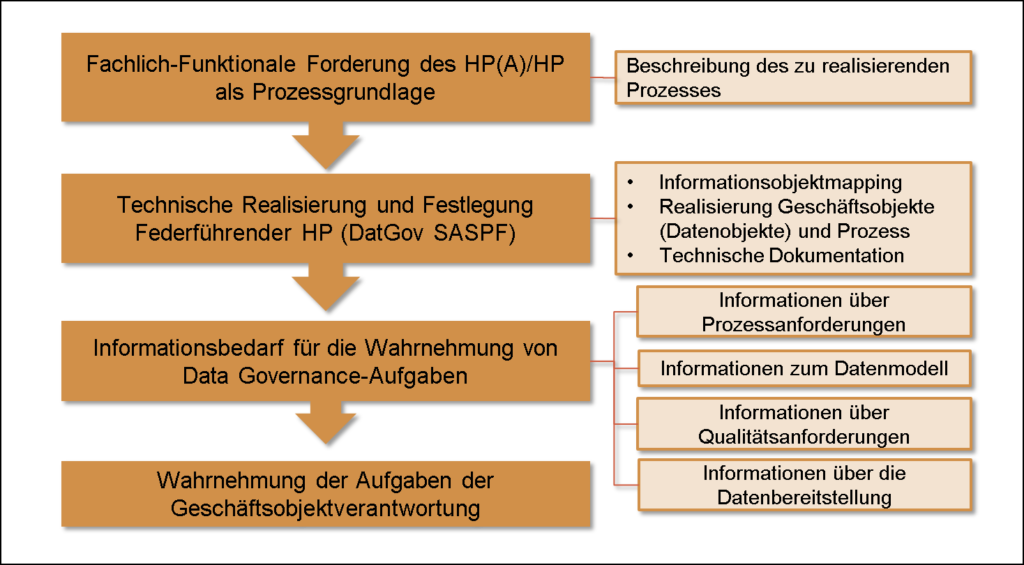

Data Governance ist die Kernkomponente des Datenmanagements. In der Bundeswehr besteht die Data Governance Organisation bereits seit 2012. Eine durchgängige organisatorische Umsetzung sowie die Schaffung der erforderlichen Regelungslandschaft erfolgte jedoch nur im Hauptprozessanteil Logistik (HP(A) Log). Die aktuellen Revisionen im Rahmen der Agenda Nutzung Teilprojekt Datenmanagement haben daher organisatorisch kaum Einfluss auf die Logistik. Die Data Governance Organisation SASPF wird künftig bestehen aus

- dem Data Governance Office SASPF bei BAAINBw G (Projekt SASPF),

- den Data Governance Offices der HP(A)/HP,

- den Datenqualitätsmanagement-Beauftragten (DQM-Beauftragten) in den Organisationsbereichen.

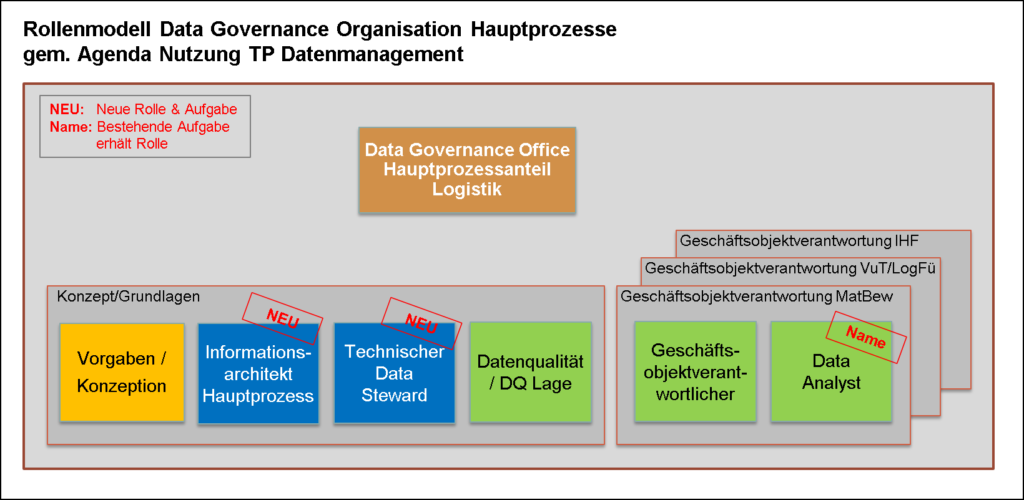

Abbildung 4: Data Governance Organisation gem. Agenda Nutzung TP Datenmanagement

Die Anforderungen an den Aufbau der Data Governance Offices der HP(A)/HP ist identisch und beinhaltet folgende Komponenten/Rollen:

- Grundlagen

- Vorgaben/Konzeption,

- Informationsarchitekt,

- Technischer Data Steward,

- Datenqualität und Lage,

- Geschäftsobjektverantwortung

- Geschäftsobjektverantwortlicher,

- Data Analyst.

Abbildung 5: Organisation Data Governance Office HP(A) Log gem. Agenda Nutzung TP Datenmanagement

Während im Bereich Grundlagen vor allem die konzeptionelle Ausgestaltung und als neue Elemente künftig die Lage zur Datenqualität sowie die Überwachung des Datenmodells (durch den Informationsarchitekten) wahrgenommen wird, betrachtet der Bereich der Geschäftsobjektverantwortung die konkreten Geschäftsobjekte, in denen die Speicherung und Verarbeitung der Daten erfolgt. Hierbei nimmt der Geschäftsobjektverantwortliche (nach aktueller Regelungslage noch Stammdatenobjektverantwortlicher) mit Unterstützung durch den Data Analyst folgende Kernaufgaben zu seinem Geschäftsobjekt wahr:

- Überwachung der Datenqualität und Vorgaben zu Datenqualitätsanforderungen,

- Vorgaben und Dokumentation im Metadatenmanagement,

- Vorgaben und Dokumentation zu Pflegeprozessen.

Die Arbeit der Data Governance Organisation beschränkte sich in der Vergangenheit stark auf die Stammdaten. Dieser Fokus wird mit der Neuausrichtung im Rahmen der Agenda Nutzung aufgehoben. Nunmehr stehen die Geschäftsobjekte als Datenrepräsentanz aller geschäftsrelevante Daten (umfasst Stammdaten, Bewegungsdaten etc.) im Fokus des Data Governance.

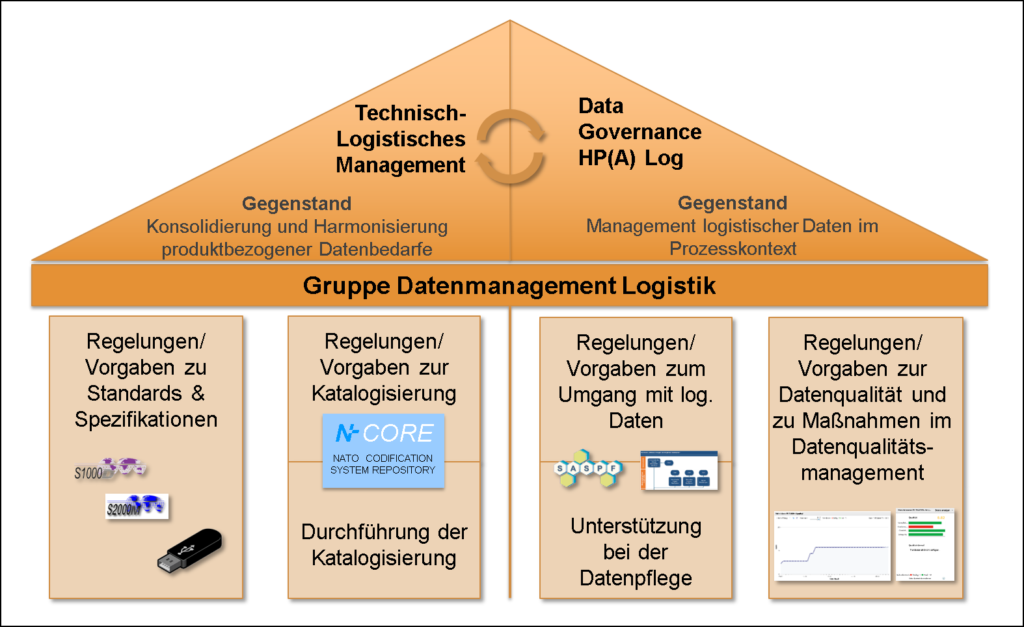

Wirkverbund Datenmanagement Logistik

Zur Operationalisierung des komplexen organisatorischen und inhaltlichen Zusammenspiels aus Prozess- und Datenmanagement sind im HP(A) Log die drei gestaltenden Kernelemente

als Wirkverbund in der Gruppe Datenmanagement Logistik im Logistikkommando der Bundeswehr (LogKdoBw) zusammengefasst. Sie stellen damit in enger Verzahnung mit dem Prozessmanagement, im Schwerpunkt dem GP TLM, ein System aus kurzfristiger operativer Handlungs- und langfristiger Steuerungsfähigkeit dar.

Abbildung 6: Wirkverbund Gruppe Datenmanagement Logistik im LogKdoBw

Zielbild

Mit der Agenda Nutzung TP Datenmanagement ist das gesamte Datenmanagement SASPF und im Kern die Data Governance Organisation kontinuierlich im Fluss. Die laufenden Veränderungen müssen in das Regelungsmanagement überführt und als Grundlage für die tägliche Arbeit konsolidiert werden. Kern hierbei ist: Organisation und ihre Prozesse müssen umgesetzt und gelebt werden – eine Managementaufgabe.

Laufende und geplante IT-Projekte, bei denen insb. der HP(A) Log seit 2015 als Bedarfsträger auftritt, sollen für

- die Implementierung eines ganzheitlichen Metadatenmanagements,

- qualitätssichernde Standardschnittstellen,

- Datenvalidierung und Konsolidierung nach Geschäftsregeln zur aktiven Steuerung der prozessbezogenen Datenqualität,

- Workflowgestützte, rollenbezogene, priorisierte Datenpflege,

- Datenqualitätslage zur kontinuierlichen Überwachung der prozessbezogenen Datenqualität

die erforderliche IT-Unterstützung schaffen.

Als strategische Zielsetzung in der Logistik, einschließlich der Umsetzung aller erforderlichen IT-Maßnahmen im Datenmanagement, steht die nachhaltige Verzahnung mit der Rüstungsindustrie und Beschaffungsprojekten auf Basis der ILS-Suite im Fokus. Standardisierung, (haushälterische) Planbarkeit für Rüstungsverträge und IT-Anpassungen, hoher Automatisierungsgrad im Datenfluss, Ausweitung der Lebenszyklusbetrachtung von Produkten auf ihre Daten und darüber liegende Prozesse sowie eine deutlich verbesserte Verfügbarkeit von Daten sind wesentliche Handlungsmotivation für dieses Zielbild. Nur so kann die erforderliche Datenqualität in einem hochagilen Umfeld von Big Data erreicht werden und die logistischen Prozesse ihre volle Wirkung entfalten.

Exkurs: Einordnung des Data Governance in Standards des IT-Management

Vergleicht man das in diesem Artikel skizzierte Data Governance mit den Empfehlungen der IT-Infrastructure Library (ITIL), die innerhalb des Geschäftsbereichs des BMVg als Standard des IT-Managements genannt werden[12], so kann man das Data Governance als eine aus der Perspektive der Datenqualität stammende spezielle Ausgestaltung der in den ITIL-Standards genannten Empfehlungen verstehen. Das Data Governance berücksichtigt alle Lebenszyklusphasen von IT, betrachtet Sachverhalte in einer e2e[13]-Sicht und fokussiert sich ebenso wie ITIL auf die Kernelemente Utility[14] und Warranty[15]. Das übergreifende Management von SASPF erfolgt über das Customer Center of Expertise SASPF/SinN[16] (CCoE). Grundlage des CCoE sind neben dem Customer Product Management[17] (CPM) und Vorgehensmodellen der SAP zur Einführung und zum Betrieb von SAP vor allem die Standards nach ITIL. Eine Integration des Data Governance a la HP(A) Log in das IT-Management SASPF bzw. in das IT-Management der Bundeswehr ist somit sichergestellt.

Schlusswort

Hiermit endet die Darstellung der drei Aufgabenbereiche der Gruppe Datenmanagement Logistik innerhalb der Abteilung Planung des Logistikkommandos der Bundeswehr.

Ausgehend vom Thema „ILS-Spezifikationen und Standards – Aktuelle Entwicklungen und Chancen für Rüstungsprojekte“ über die „Katalogisierung im Rahmen des AC/135 – eine nationale und internationale Aufgabe“ bildet dieser Artikel mit der Darstellung des „Data Governance Office im Hauptprozessanteil Logistik – Vom Nutzen der Daten“ die Klammer über die Daten im Hauptprozess Logistik und damit dem Auftrag der Gruppe.

Die Erfüllung der drei Aufgabenbereiche erfordert eine hohe spezialisierte Ausbildung der 162 zivilen und militärischen Mitarbeiterinnen und Mitarbeiter der Gruppe in den entsprechenden Verfahren. Diese Ausbildung findet üblicherweise parallel zur täglichen Arbeit in monatelanger Einzelausbildung am Arbeitsplatz statt, da die Regenerationsrate eine lehrgangsgebundene Ausbildung nicht begründet.

Autoren: Oberstleutnant Manfred Klaffus und Oberstleutnant Heiko Saß, LogKdo Bw, Abteilung Planung III DatMgmt Log

[1] Bezeichnet Datenmengen, die aufgrund ihrer Beschaffenheit (z. B. zu groß, zu komplex, zu schnelllebig, zu schwach strukturiert) nicht mit manuellen und herkömmlichen Methoden der Datenverarbeitung ausgewertet werden können.

[2] Die integrativen Prozesse umfassen die organisationsunabhängige Gesamtheit der fachlichen Abläufe eines Aufgabengebiets, einschließlich der Abhängigkeiten und Wechselwirkungen zu anderen integrativen Prozessen, vgl. A-520/1 Prozesslandkarte, Rollenkonzept und Implementierung des Prozessmanagements.

[3] Betrifft die Arbeitsvorgänge Logistikprozess überwachen und steuern, Logistische Unterstützung planen und befehlen und Maßnahmenbereich Materialwirtschaft (MatWi) bearbeiten.

[4] Der Begriff Geschäftsobjekt wird im Rahmen der Agenda Nutzung Teilprojekt (TP) Datenmanagement und des IT-Projektes Master Data Governance (MDG) eingeführt und umfasst jedes eindeutig bestimmbare Objekt, welches zur Speicherung oder Verarbeitung geschäftsrelevanter Daten verwendet wird, z. B. Stammdatenobjekte wie Materialstamm, Bewegungsdatenobjekte wie die Umlagerungsbestellung.

[5] Integrated Logistics Support.

[6] ASD/AIA S2000M (International Specification for Material Management) – Die Anwendung der S2000M für den automatisierten Datenaustausch mit Auftragnehmern ist für die Beschaffung bereits seit vielen Jahren angewiesen. Aufgrund des vollautomatischen Datenaustausches wird dieses Verfahren durch die Katalogisierungsstelle der Bundeswehr (KatStBw) für die nationale Katalogisierung immer angestrebt.

[7] Daten sind Symbole und Zeichen (Syntax) und für die maschinelle Verarbeitung erforderlich. Informationen sind in einem konkreten Bedeutungskontext interpretierte und verknüpfte Daten (Aufgabe, Rolle etc.) (Semantik). So kann aus einer Zahlenfolge in Abhängigkeit des Verwendungskontextes eine Kontonummer oder eine Postleitzahl interpretiert werden. Die subjektive Interpretation von Informationen über kognitive Fähigkeiten führt zu Wissen.

[8] Die von der Bundeswehr im Rahmen der Prozessmodellierung angewandte Methode ARIS (Architektur integrierter Informationssysteme) nutzt zur Systematisierung die Prozess- bzw. Steuerungs-, die Daten-, die Funktions-, die Leistungs- und die Organisationssicht auf einen Prozess.

[9] Datenqualität (Erfüllung der Qualitätskriterien) liegt immer vor, wenn die Daten für ihren Verwendungszweck (Prozess) geeignet sind.

[10] Eingehende Beschreibung erfolgte bereits in cpm-Verlag, Ausgabe 1-2019 (S. 43-47) und „blauer Bund e.V.“ – Beitrag vom 7. Januar 2019.

[11] Eingehende Beschreibung erfolgte in cpm-Verlag, Ausgabe 2-2019.

[12] Vgl. IT-Strategie v. 02.12.2015 oder K-3107/2 IT-Service Management Ausrüstung & Nutzung.

[13] End-to-End: bedeutet in der Bundeswehr die Sicherstellung der konsistenten Zusammenarbeit verschiedener Anwendungen und Systeme mit dem Ziel, durchgängige Geschäftsprozesse zu gewährleisten, einschließlich des dazu erforderlichen Änderungsmanagements. Ziel ist, eine Gesamtsicht auf die an einem Prozess beteiligten Systeme aus der Perspektive des Nutzers herzustellen, vgl. A1-945/0-7001.

[14] Brauchbarkeit, Nützlichkeit, Nutzen.

[15] Gewährleistung, Zusicherung, Garantie.

[16] A1-945/0-7001 Customer Center of Expertise Standard-Anwendungs-Software-Produkt-Familien/Systeme in Nutzung.

[17] A-1500/3 Customer Product Management.